News d'aujourd'hui

[Mise à jour] OpenAI propose une IA LLM générative en libre-accès et en deux tailles

[MàJ par Philippe]

À la question-piège "Que peut-on faire un week-end de vacances à Limoges", rien ne m'a été épargné dans sa version 20B (20 milliards de paramètres/weights) nécessitant déjà 24 Go de RAM sur un Mac ARM.

La porcelaine ou les céramiques? Non.

Les promenades le long de la Loire? Oui.

La visite du chateau de Chambord? Oui, aussi!

À cette échelle (20B) c'est la plus mauvaise IA que j'ai essayé!

En bonus pour lui Oradour-sur-Glane se résume à une auberge! Si si!

À la place il recommande le Parc Naturel du Morvan, ou le Parc d'attraction du Puy de Dôme. Il n'a pas vraiment le compas dans l'œil.

[Article initial]

OpenAI avait été originellement créé pour proposer des IA en libre-accès, et a depuis changé son fusil d'épaule, devenant un mammouth des IA payantes via abonnement ou accords avec des partenaires comme Apple et surtout Microsoft. Les différents ChatGPT.

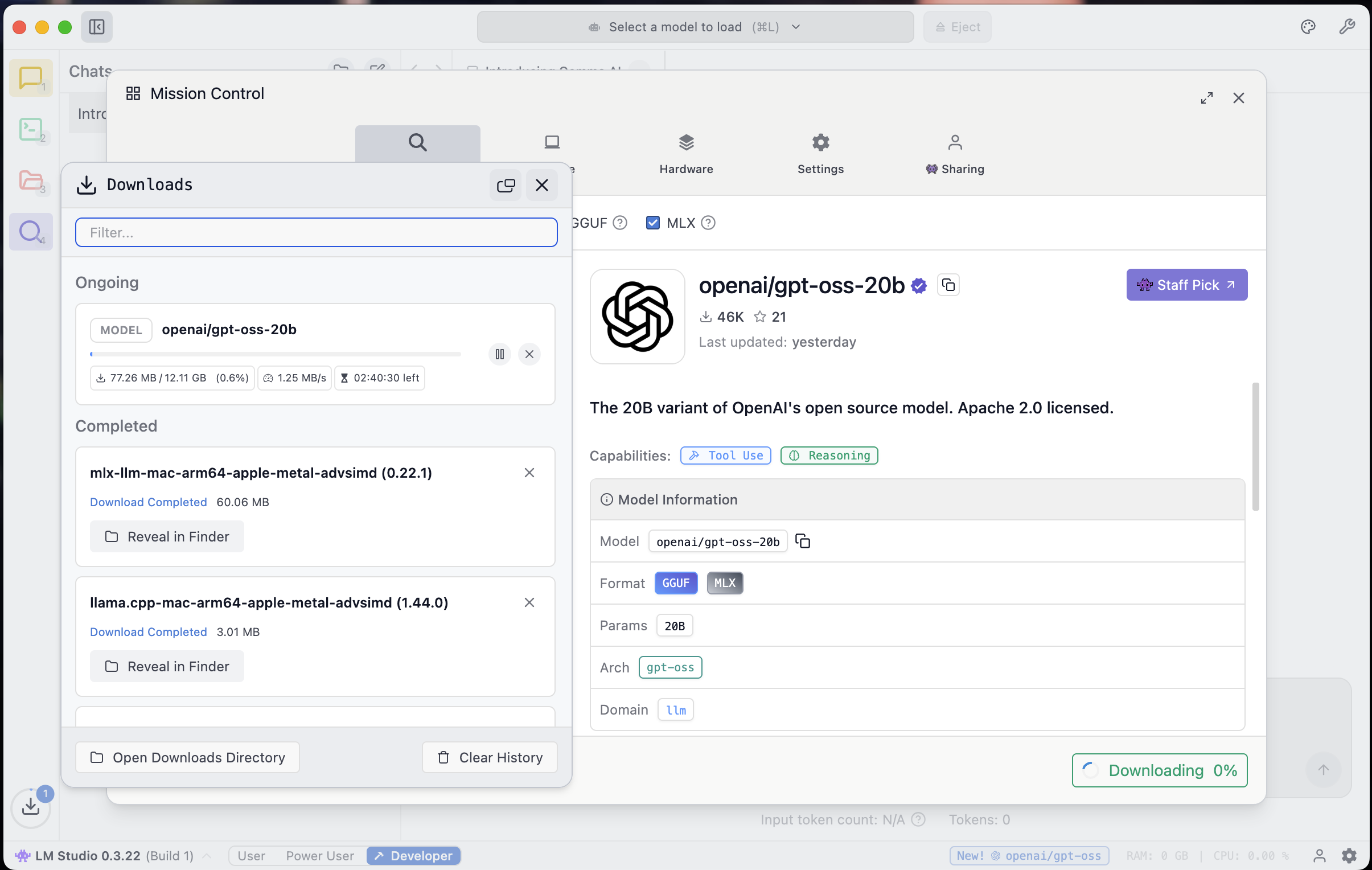

Le modèle GPT-OSS vient d'être proposé avec 20 milliards ou 120 milliards de paramètres (weights), et maintenant accessibles via LM Studio, ou téléchargeables séparément, en accès-libre.

Néanmoins nombre d'entre nous auront une belle déconvenue, car si des sites indiquent que le plus petit modèles (20 milliards de paramètres/weights) tournerait sur un Mac récent avec 16 Go de RAM, ça n'est malheureusement pas possible.

Pour faire tourner le plus petit modèle, il vous faut un Mac ARM avec 24 Go de RAM au minimum.

Alternativement sur PC, une dGPU avec 16 Go de RAM comme l'excellente et abordable GeForce RTX 5060 Ti 16 Go.

Le modèle avec 120 milliards de paramètre devrait tourner sur un Mac ARM avec 96 Go de RAM sans que je puisse le vérifier dans ce cas. Avec 128 Go de RAM ça passera large.

Je vais lui faire passer mes petits "benchmarks" ce soir.

- Jour précédent

- Jour suivant

Etes-vous tenté par le nouveau Mac mini M4 ?

Total des votes : 3883